Jedes Unternehmen speichert eine Unmenge an Daten. Die Relevanz, die diese Informationen für das Treffen unternehmerischer Entscheidungen haben, ist somit unbestritten. Dennoch verfügen nur die wenigsten mittelständischen Firmen über ein Datenqualitätsmanagement. Die Folgen sind gravierend !

Sicherung der Datenqualität als zentraler Erfolgsfaktor

Die Datenqualität entscheidet, ob die Realität mit den Daten adäquat abgebildet wird. Besonders die Verlässlichkeit der Informationen ist wichtig für ihre Eignung als Planungs- und Entscheidungsgrundlage. Mit einem konsequenten Datenqualitätsmanagement wird sichergestellt, dass die Qualität der genutzten Datenbasis ausreichend hoch ist und somit auch die Voraussetzungen für Business Intelligence und eine hohe Entscheidungsqualität gegeben sind.

Das Datenqualitätsmanagement rückt als wichtige Managementaufgabe immer mehr in den Fokus der Unternehmensführung. Es umfasst organisatorische, konzeptionelle und technische Maßnahmen und kann nur wirksam werden, wenn über das Management hinaus eine unternehmensweite Sensibilisierung für die Relevanz des Themas erreicht wird.

Ohne ein effizientes Datenqualitätsmanagement können die Anforderungen, die aus dem Kundenmanagement und dem Risikomanagement resultieren, nicht erfüllt werden. Außerdem erfordern die Harmonisierung der Geschäftsprozesse und die Dokumentationspflichten gegenüber den Kunden und staatlichen Einrichtungen die Beachtung von Qualitätskriterien bei der Informationsverarbeitung. Nicht zuletzt sind Kriterien hinsichtlich der Sicherheit und des Datenschutzes zu beachten.

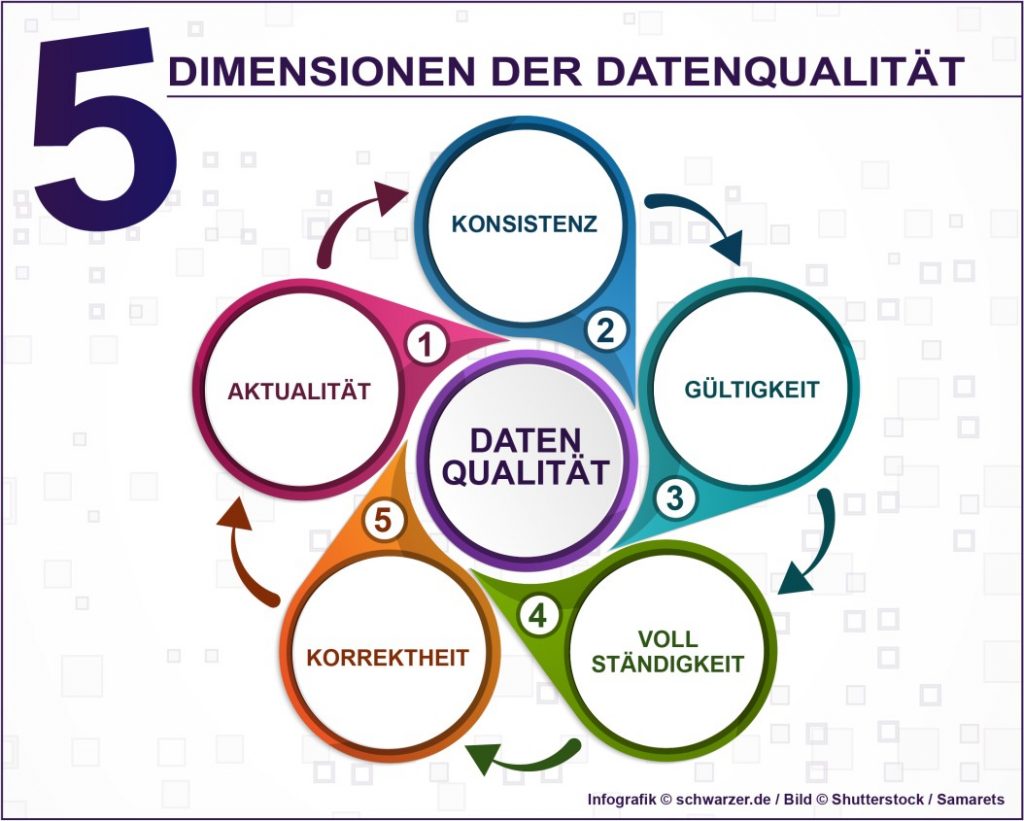

Unter dem Begriff Data Governance werden die Prozesse, Verfahren und Personen zusammengefasst, die zusammen das Datenqualitätsmanagement bilden, also dafür sorgen, dass die Datenbasis aktuell, konsistent und korrekt ist. Zum Datenmaterial gehören neben den Kundendaten auch Produkt-, Logistik- und Mitarbeiterdaten. Nur wenn das Datenqualitätsmanagement gut in die anderen Unternehmensprozesse integriert wird, kann es seine umfangreichen Aufgaben erfüllen. Kundenwünsche werden verstanden und Produktionsabläufe optimiert. Idealerweise werden im Sinne des Big Data auch Informationen über den Markt und die Wettbewerber einbezogen.

Video: WS II Sicherung der Datenqualität, Haftungsfragen und Nutzungsbedingungen

Was bedeutet Datenqualität?

Die Qualität der Informationen ist definiert als deren Eignung, den Zweck zu erfüllen, der mit der Datengenerierung beabsichtigt wurde. Letztlich bilden Daten die Realität ab und die Qualität ist das Kriterium, das anzeigt, wie gut dies gelingt. Die extrahierten Informationen müssen für operative und analytische Anwendungen einsetzbar sein, damit sie dem Management als Planungsbasis dienen können. Den meisten Firmen sind die Zusammenhänge zwischen der Datenqualität und dem Geschäftserfolg durchaus bewusst. Aus diesem Grund wird ein integriertes Datenqualitätsmanagement, das alle Unternehmensbereiche und externe Quellen umfasst, zumindest angestrebt. Eine vorherige umfassende Datenanalyse ist daher unumgänglich.

Aufgabe dieses Datenqualitätsmanagements ist es, sicherzustellen, dass die Stamm- und Bewegungsdaten unternehmensweit zunächst korrekt erhoben und anschließend korrekt verwaltet werden. Nur wenn dies gelingt, kann die Wettbewerbsfähigkeit erhalten und weiter ausgebaut werden. Außerdem ist das Datenqualitätsmanagement eine unabdingbare Voraussetzung für Big Data.

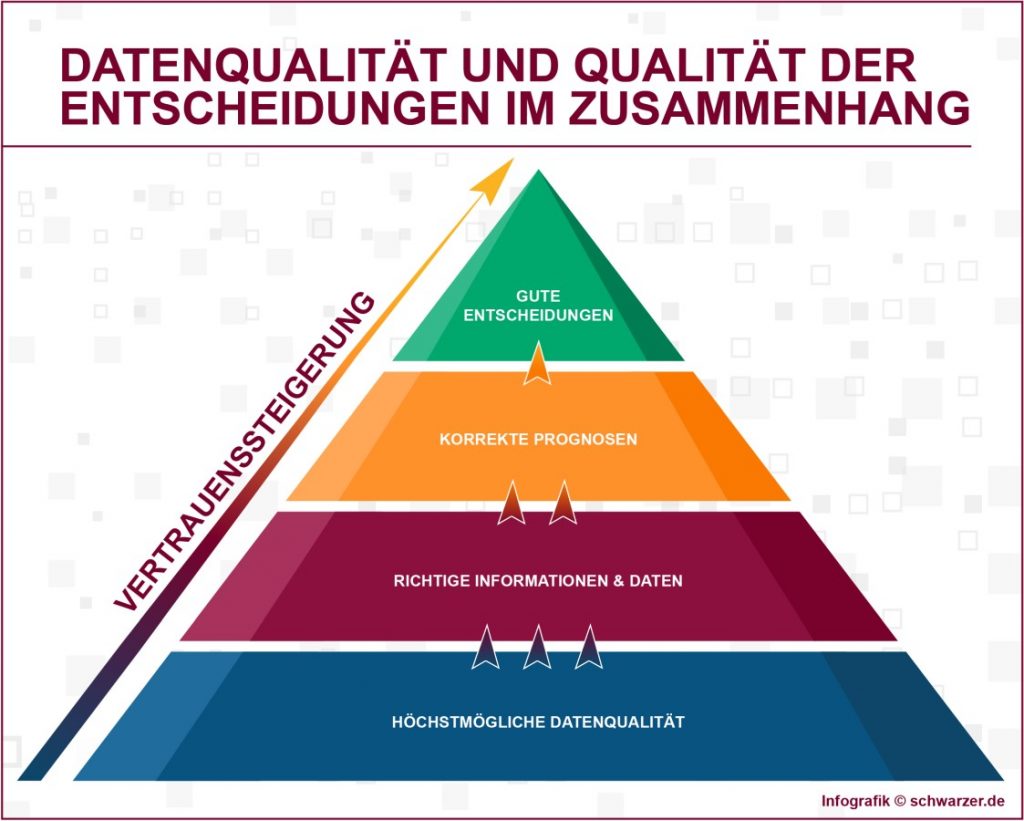

Es ist extrem wichtig, dass sich das Management auf die Qualität der Datenbasis verlassen kann, also ein Vertrauen hinsichtlich der Informationen besteht. Das wird besonders in kritischen Situationen, die ein schnelles Agieren des Managements erfordern, deutlich. Zweifel an der Datenbasis und letztlich mangelndes Vertrauen machen dann aufwendige Nachprüfungen durch das Controlling erforderlich. So gehen wertvolle Zeit und damit auch Handlungsspielräume verloren. Folge sind ad hoc Entscheidungen, die das Gegenteil einer strategischen Unternehmensführung sind.

Die Relevanz des Datenqualitätsmanagements für den Unternehmenserfolg

Eine Studie hat ergeben, dass Unternehmen zu 52 Prozent die Qualität der Daten als sehr erfolgskritisch betrachten. 38 Prozent bewerten sie als etwas kritisch und nur 10 Prozent gaben an, dass die Informationsqualität nicht kritisch ist. Laut einer Umfrage der Deutschen Gesellschaft für Daten- und Informationsqualität (DGIQ) ist die Datenqualität sogar für 90 Prozent aller Unternehmen ein wichtiger Erfolgsfaktor. Diese Erkenntnis führt dazu, dass in den Unternehmen vermehrt Anstrengungen unternommen werden, durch Data Cleansing (Datenbereinigung) die Qualität der Datenbasis zu verbessern, um anschließend Business Intelligence Tools oder Business Analytics Tools einzusetzen.

Big Data als Herausforderung und Potential eines zukunftsgerichteten Managements ist das Ziel, das über den Zwischenschritt Clean Data angestrebt werden soll. Das Informationszeitalter erfordert eine Neuausrichtung des Datenmanagements, denn ansonsten wird das Handling der exponentiell wachsenden Datenmengen unmöglich. Die Anforderungen an die IT-Systeme werden dabei ebenfalls immer komplexer. Wird Big Data realisiert, bedeutet das nichts anderes als die korrekte Generierung und anschließende Weiterverarbeitung sowie Pflege des Datenmaterials aus unterschiedlichsten strukturierten und unstrukturierten Quellen.

Für die meisten Produktionsunternehmen des Mittelstands ist diese Aufgabe durchaus zu bewältigen, denn anders als bei den Firmen im Bereich E-Commerce und Finanzen sind die Datenmengen überschaubar. Die zur Verfügung stehenden Speichermedien und auch die Kapazität an Arbeitsspeicher der Server sind ausreichend, um alle Stamm- und Bewegungsdaten optimal zu managen. Viel wichtiger ist, dass diese Informationen auch korrekt sind. Die Zuverlässigkeit der Daten, die als Entscheidungsgrundlage herangezogen werden, ist von zentraler Bedeutung für den Unternehmenserfolg, denn diese beeinflussen die Bewertung von Marktchancen, werden außerdem bei Verhandlungen benötigt und zur Ermittlung von Kennzahlen genutzt. Es ist offensichtlich, dass die Qualität dieser Entscheidungen direkt mit der Qualität der Datenbasis korreliert, wobei das Datenvolumen darauf keinen Einfluss hat. Deshalb ist es auch für mittelständische Unternehmen wichtig, ein effizientes Datenqualitätsmanagement zu implementieren.

Ziel jeglichen unternehmerischen Handelns ist das Erreichen von Wettbewerbsvorteilen, mit denen die Marktposition gesichert und möglichst weiter ausgebaut wird. Die meisten Firmen sind sich laut einer Studie durchaus bewusst, dass eine mangelhafte Datenqualität direkte Auswirkungen auf alle Bereiche ihrer Wertschöpfungskette hat. (#01)

Datenqualitätsmanagement als Prämisse für den wirtschaftlichen Erfolg

Ziel jeglichen unternehmerischen Handelns ist das Erreichen von Wettbewerbsvorteilen, mit denen die Marktposition gesichert und möglichst weiter ausgebaut wird. Die meisten Firmen sind sich laut einer Studie durchaus bewusst, dass eine mangelhafte Datenqualität direkte Auswirkungen auf alle Bereiche ihrer Wertschöpfungskette hat. Ganz entscheidend sind dabei die Prozesse entlang der Lieferketten. Trotzdem versucht laut einer Befragung nur ein knappes Zehntel der Firmen, mit einem professionellen Datenqualitätsmanagement die Situation aktiv zu verbessern.

Gleichzeitig wurde in der Studie herausgearbeitet, dass die Qualität der Daten derzeit sogar abnimmt. Das ist nicht verwunderlich, denn das Datenvolumen steigt immer weiter. Wenn diesem unumkehrbaren Trend keine Bemühungen folgen, ein Datenqualitätsmanagement zu implementieren, ist eine weitere negative Entwicklung vorprogrammiert. Der Grund für diese Diskrepanz ist die mangelnde Einsicht oder vielmehr Bereitschaft, in ein professionelles Management der Datenqualität Zeit und Geld zu investieren. Derartige Investitionen zahlen sich jedoch einerseits aus und andererseits verursachen fehlerhafte Daten auch direkte und indirekte Kosten. Weil es jedoch nicht einfach ist, die Auswirkungen eines fehlenden Datenqualitätsmanagements zu quantifizieren, fällt es den Entscheidungsträgern in den Unternehmen schwer, Änderungshemmnisse zu überwinden.

Jedes Unternehmen speichert eine Unmenge an Daten über seine Produkte, Kunden sowie die eigenen Mitarbeiter. Die Relevanz, die diese Informationen für das Treffen unternehmerischer Entscheidungen haben, ist auch unbestritten. Dennoch verfügen nur die wenigsten mittelständischen Firmen über ein Datenqualitätsmanagement. (#02)

Die Kosten mangelnder Datenqualität

Jede betriebswirtschaftliche Entscheidung wird vor dem Hintergrund von Kosten und Erlösen gefällt. Um die Notwendigkeit der Implementierung eines Datenqualitätsmanagements zu untermauern, sollen aus diesem Grund im Folgenden die monetären und nicht-monetären Auswirkungen einer mangelhaften Datenbasis näher analysiert werden.

Eine mangelhafte Datenbasis hat direkte und indirekte Auswirkungen. Oft sind die direkten Auswirkungen auf den ersten Blick wenig dramatisch. Bei näherer Betrachtung wird jedoch deutlich, dass in den meisten Fällen mit den direkten auch indirekte Folgen verbunden sind, die darüber hinaus wesentlich schwerwiegender sind. Dieser Zusammenhang und die langfristigen Auswirkungen werden jedoch gar nicht wahrgenommen oder zumindest hinsichtlich ihrer Bedeutung unterschätzt.

Ganz besonders im Bereich der Kundenkommunikation sind die negativen Auswirkungen fatal. Wird ein Kunde beispielsweise vom Vertrieb kontaktiert, obwohl er mit seinem Kundenbetreuer etwas anderes abgesprochen hatte, geht Vertrauen verloren und die Kundenbeziehung wird belastet. Den gleichen Effekt haben Lieferverzögerungen und falsch gestellte Rechnungen. Alle drei Fälle wären leicht zu vermeiden, wenn die korrekten Daten an der richtige Stelle vorliegen würden. Leider ist mit all diesen Problemen die Gefahr verbunden, dass der Kunde zur Konkurrenz wechselt. Ist der Kunde sehr verärgert, wird er dies vielleicht sogar in den Social Media oder Internet-Foren kommunizieren, was den negativen Effekt multipliziert und schwere Imageschäden sowie sinkende Umsätze nach sich zieht.

Ein weiterer Bereich, der von einer mangelhaften Qualität der Datenbasis negativ tangiert wird, ist die Produktion. Hier können schon minimale Abweichungen im Datenbestand Fehlentscheidungen und damit erhebliche wirtschaftliche Folgen verursachen. Nicht mehr aktuelle Materialpreise führen beispielsweise zu einer falschen Bewertung der Marge. Darüber hinaus gestalten sich Prozesse ineffizient, wenn ständig Korrekturen an den Datengrundlagen notwendig werden, denn das korrigierende Eingreifen führt zu Friktionen und verhindert reibungslose Abläufe.

Wird fehlerhaftes Datenmaterial in Prüfberichte oder die Bilanz übernommen, erschwert dies die Einhaltung von Compliance-Vorgaben und verfälscht im schlimmsten Fall die Unternehmensbilanz, was mit hohen Geldbußen geahndet werden kann.

Obwohl die oben dargestellten Zusammenhänge nachvollziehbar sind, ist es dennoch schwierig, die monetären Auswirkungen fehlerhafter Daten exakt festzustellen. Es ist relativ einfach zu berechnen, was zusätzliche Arbeitsstunden, Retouren oder Zinsen kosten, die aufgrund von datenbasierten Fehlentscheidungen anfallen. Weitaus schwieriger ist es, Imageverluste und Abwanderung von Kunden sowie eine sinkende Mitarbeitermotivation zu bewerten. Das bedeutet jedoch nicht, dass diese Kosten nicht existieren. Eine Studie des Forschungsinstituts für Rationalisierung e. V. an der RWTH Aachen (FIR) ergab, dass aufgrund von Datenqualitätsproblemen den Herstellern Kosten in Höhe von 0,5 Prozent des Umsatzes entstehen und damit die betriebswirtschaftlichen Auswirkungen ganz erheblich sind.

Video: Datenqualität: Gespräch zwischen zetVisions und Lünendonk

Neue Problemfelder: Automatisierung und Datenverdichtung

Das Datenvolumen steigt allgemein rasant an und das betrifft alle Bereiche der Gesellschaft, ganz besonders die Unternehmen. Eine zunehmende Vernetzung und die Tendenz zur Globalisierung führen dazu, dass eine Firma immer mehr Informationen berücksichtigen muss, um möglichst optimale Entscheidungen zu treffen. Es ist wichtig, rechtzeitig Chancen und Risiken zu identifizieren und dann schnell zu handeln, um gegenüber der Konkurrenz einen Wettbewerbsvorteil zu erreichen.

Das steigende Datenvolumen stellt wiederum Anforderungen an das Datenqualitätsmanagement. Weil die riesigen Datenmengen zunehmend automatisch erfasst und verwaltet werden, ist es notwendig zu erkennen, welche Informationen nicht konsistent, fehlerhaft, nicht mehr aktuell oder vollständig sind. Gelingt es nicht, das Datenmaterial zu bereinigen, führt dies zu vermeidbaren Wiederholungsfehlern. Durch die zunehmende Automatisierung fehlt an vielen Stellen der kritische Blick eines Mitarbeiters auf das Datenmaterial und damit geht eine wichtige Kontrollinstanz verloren. Die Plausibilitätsprüfung an den Schnittstellen entfällt in vielen Firmen und das birgt große Gefahren bei der weiteren Datenverarbeitung.

Eine Ursache liegt wahrscheinlich darin, dass in vielen mittelständischen Firmen bisher der Faktor Mensch immer noch als Korrektiv vorhanden war und eingreifen konnte. Besonders an den Schnittstellen übernehmen Mitarbeiter oft weiterhin bewusst oder unbewusst Plausibilitätsüberprüfungen und korrigieren dann „direkt vor Ort“ das Datenmaterial. Erst wenn sich die nötigen Korrekturen häufen und Prozesse nicht mehr reibungslos ablaufen, entsteht ein Problembewusstsein. Betrachtet man nun die Entwicklung hin zur Industrie 4.0 wird ersichtlich, dass der Mensch als Korrektiv zunehmend wegfällt. Es ist ja das Ziel der Digitalisierung, dass die Systeme automatisiert miteinander kommunizieren. Wenn der Mensch als Prüfinstanz ausfällt, muss dieses Vakuum geschlossen werden und an dieser Stelle müssen andere Methoden zur Anwendung kommen, um ein Datenqualitätsmanagement zu institutionalisieren. Firmen, die sich in der Zwischenphase befinden, also zunehmend Mitarbeiter aus den Prozessen des Datenmanagements abziehen und auf automatisierte Prozesse setzen, ohne gleichzeitig ein Datenqualitätsmanagement zu implementieren, sind besonders gefährdet.

Zeitgleich erfolgt eine immer stärkere Vernetzung und zwar sowohl unternehmensintern wie auch unternehmensextern. Damit multiplizieren sich die Auswirkungen einer mangelhaften Datenqualität, die in die verschiedenen Bereiche hineingetragen wird. Sind die Informationen im System abgespeichert, greifen alle Unternehmensbereiche darauf zu und im schlimmsten Fall entsteht ein Domino-Effekt, der kaum noch aufzuhalten ist. Aus einem vermeintlich kleinen Fehler resultieren dann schwerwiegende Fehlentscheidungen, deren Ursachen zudem sehr schwer nachvollziehbar sind.

Vorteile der Automatisierung für das Datenqualitätsmanagement

Die beschriebenen Probleme, die eine steigende Automatisierung verursacht, sind jedoch nur eine Seite der Medaille. Auf der anderen Seite bietet gerade die Automatisierung auch wesentliche Vorteile und beseitigt Hindernisse auf dem Weg zum integrierten Datenqualitätsmanagement. Eine automatische Datenerfassung hat ein geringeres Fehlerpotential als die manuelle Datenerfassung. Außerdem sind automatisierte Datenflüsse eine hervorragende Möglichkeit, sicherzustellen, dass zwischen verschiedenen Produktionsstandorten oder Funktionsbereichen die notwendigen Informationen ausgetauscht werden. Im Folgenden wird näher erläutert, wie ein effizientes Datenqualitätsmanagement implementiert werden und dabei auf den Potentialen zunehmender Automatisierung aufbauen kann.

Implementierung eines Datenqualitätsmanagements

Das Datenqualitätsmanagement sollte ins allgemeine Qualitätsmanagement integriert werden und somit auch die allgemeinen Normen des Qualitätsmanagements übernehmen. Dabei ist eine Kunden-, Prozess- und Ergebnisorientierung wichtig sowie die permanente Weiterentwicklung, die nur durch Interaktion mit allen beteiligten Interessensgruppen erreicht werden kann. Es ist sinnvoll, schrittweise vorzugehen und zunächst mit einem Projekt zu beginnen und dabei in einem Bereich zu starten, in dem mangelnde Datenqualität ein offensichtliches Problem darstellt. Auf diese Weise werden relativ schnell Verbesserungen erreicht und außerdem gewinnt das Business Erfahrungen und Sicherheit bei der Implementierung des Datenqualitätsmanagements.

Zu Beginn wird eine Anforderungsanalyse vorgenommen, deren Ergebnisse im Data Governance dokumentiert werden. Unternehmensweit geltende Datenqualitätsregeln ermöglichen dann die Messung der Datenqualität und auch die Definition von Zielen und Standards. Ergebnis sind organisatorisch verankerte, strukturierte Prozesse, mit denen aus Informationen handlungsrelevantes Datenmaterial gewonnen wird. Dafür ist es nötig, personelle Ressourcen bereitzustellen. Denn trotz aller Einsicht in die Notwendigkeit eines Datenqualitätsmanagements sucht man in vielen mittelständischen Firmen noch vergeblich nach zuständigen Datenbeauftragten. Aus diesem Grund müssen die entsprechenden Positionen in der IT-Abteilung aber auch in den Fachabteilungen geschaffen werden und zunächst besteht deren zentrale Aufgabe darin, die Qualitätskriterien zu definieren.

Im täglichen Business ist nicht zuletzt das Thema Datensicherheit wichtig. Die Qualität der Informationen ist von großer Bedeutung für den Datenschutz. Ohne ein Datenqualitätsmanagement kann die Sicherheit des Datenschutzes nicht gewährleistet werden. (#04)

Datensicherheit als Kernaufgabe des Datenqualitätsmanagements

Im täglichen Business ist nicht zuletzt das Thema Datensicherheit wichtig. Die Qualität der Informationen ist von großer Bedeutung für den Datenschutz. Ohne ein Datenqualitätsmanagement kann die Sicherheit des Datenschutzes nicht gewährleistet werden. Im Bereich Datenschutz geht es zum einen um das Entfernen falscher Informationen. Das Bundesdatenschutzgesetz (§ 20 BDSG) verlangt ausdrücklich, dass nicht korrekte personenbezogene Daten gelöscht werden müssen.

Darüber hinaus sollte ein Konzept erarbeitet werden, das ein Höchstmaß an Datensicherheit gewährleistet. Es geht nicht nur um die gewärleistete Datensicherheit, auch die Datenmengen müssen gehändelt werden. Business Analytics Tools helfen dabei. Es müssen beispielsweise alle Stellen innerhalb der IT-Infrastruktur berücksichtigt werden, an denen schützenwerte Informationen gespeichert sind. Eine Verschlüsselung wird unwirksam, wenn es an anderer Stelle Speicherorte gibt, an denen die sensiblen Informationen für Unbefugte unverschlüsselt zugänglich sind. In diesen Fällen kann kein ausreichender Datenschutz erreicht werden. Auch die Datenkategorisierung ist ein Bereich, der den Datenschutz und das Datenqualitätsmanagement gleichermaßen tangiert. Es muss feststehen, welche Informationen als besonders schützenswert gelten und deshalb verschlüsselt werden müssen.

Das Datenmaterial sollte genauso wie das Produktionsmaterial als Vermögenswert des Unternehmens betrachtet werden. Im Bereich der Datenverarbeitung haben sich in vielen Firmen Insellösungen etabliert und es ist eine große Herausforderung, diese zu einem einheitlichen Datenqualitätsmanagement zu integrieren. Gelingt dies jedoch, sind die Vorteile immens. Zum einen wird der Aufwand für die Daten-Vervielfältigung erheblich verringert und zum anderen kann der Personaleinsatz für die Kontrolle und die Pflege des Datenmaterials reduziert werden. Aufwendige Korrekturen und mühsame Fehlersuchen können ebenfalls auf ein Minimum beschränkt werden, wenn von vornherein auf eine hohe Datenqualität geachtet wird. Nicht zuletzt wird gewährleistet, dass die Datenschutzbestimmungen und Branchenvorgaben eingehalten werden. Damit wird wiederum das Risiko von Imageschäden und Rechtsstreitigkeiten verringert und die Sicherheit erhöht.

Bildnachweis:©Shutterstock-Titelbild: twobee -#01: arka38 -#02: Den Rise -#04: illion Photos